After Effectsに求めること (妄想)

- コンポジション毎にレンダリング設定, 出力パスを保持できる

- ↑に加えて, 静止画書き出しの設定も保持できる

- 出力パスのテンプレート文字列に, 日付フォーマット追加

- コンポジションのレイヤーのフォルダ機能

- Bool値のキーフレームは, 形状や色で真偽を判別できる

- プロジェクトファイルごとに, 連番のデフォルトFPSを設定できる

- レイヤー選択状態でショートカットキーでSpotlight的な小窓が開く. インクリメントサーチでエフェクトを追加できる (C4DのShift+Cに相当)

- エフェクト&プリセット フォルダ名でも絞り込めるように. (ベンダー名の検索にも対応)

- レイヤーインスタンス機能. エフェクトを加えた調整レイヤーなどを, そのままインスタンスとして複製でき, 他コンポジションで再利用できる. 元の調整レイヤーを変更すると, インスタンスに反映される.

- AEP同士のDiff, マージ機能

- ExtendScript, ES6とCommonJSのサポート

- コンソールウィンドウ

新しいコンポジションの種類

子コンポジション

普通のコンポジションから, 再利用性を一切抜いたもの. 特定のコンポの中に, 一度のみ使われる.

TCも親コンポに同期していて, プロジェクトパネル上でも親コンポの子要素として表示される. フォルダ機能にも近く, 親コンポのレイヤーパネルの中で, Finderのツリー表示よろしく展開することもできる.

クラスコンポジション

普通のコンポジションは再利用性がある一方, 再利用先のコンポ内でそれぞれに別の見え方になるような設定を個別にできなかった. クラスコンポジションは, よりコンポジションを抽象化することで, そういった問題を解決する. コンポジション自体に, カスタムプロパティを設定できる. 「コントロールエフェクト」をコンポジションに追加できるイメージ. そのプロパティはエクスプレッションを用いてコンポ内のレイヤーのプロパティとひも付けることができる. 再利用先の親コンポから, クラスコンポジションのカスタムプロパティを設定することで, クラスプロパティ内のレイヤーを再利用先から間接的に制御できるようになり, ある種のカプセル化が可能になる.

ofxAEKeyframe

最近やった撮影で効率化のためにoFで自動撮影するシステム組んだんですが、なんかaddonに出来そうな雰囲気を醸してたのでまとめてみました。初addon。

oF側からAfterEffectsにキーフレームをコピペ出来るやつです。

比嘉さんのofxAfterEffectsKeyframeParserが、AEのキーフレームのデータをoF側でパースするaddonだったんで、丁度その逆です。

映像制作にも楽器を弾くかのような即興性があれば良いのになって前々から思ってたけど、Adobeは謎ニッチな機能ばかりAEに追加するし、自分で作るしか無いなぁと最近は諦めてます。

このaddon使えば、LeapMotionで取った手の動きとかをAEに読み込めたりするんで、かなり俺得な作業環境作れそう。

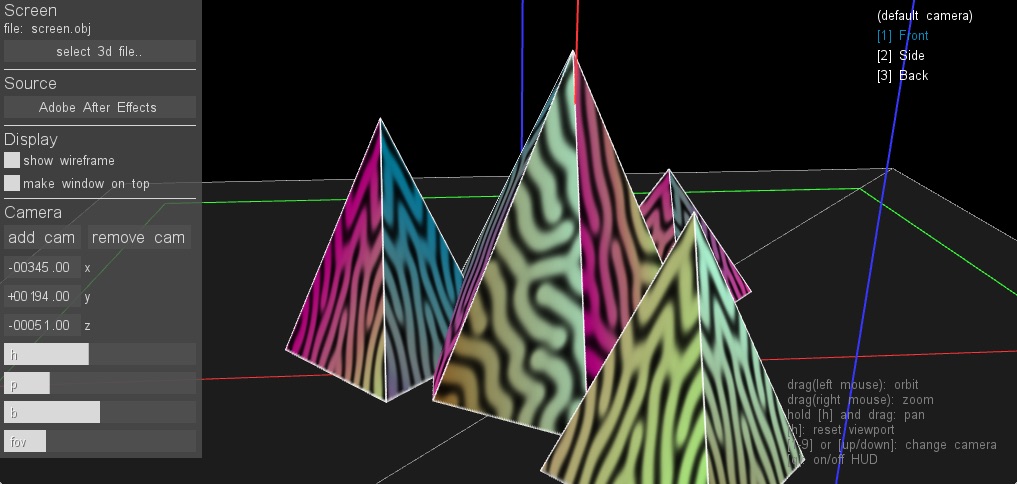

プロジェクションマッピング制作支援ツールつくった

スクリーンの形状が複雑なプロジェクションマッピングの制作は、その展開図の上に映像をのせていくわけですが、立体スクリーンに投影された所をリアルタイムで確認しながらコンポジットできたら便利だなーと思い、ツールをつくりました。久々のoFです。

VirtualMapper ( source )

ネーミングセンス無くてすみません。(良い案あったら教えてください)

要するに、UV付きのモデルデータを読み込んで、Syphon(ソフト間で映像をやりとりするためのオープン規格)経由で送信された映像をテクスチャとしてリアルタイム表示するというツールです。

C4Dでモデルデータの書き出し、Syphonの出力をAfter Effectsから行った時の画面キャプチャです。

たいていのVJソフトやビジュアルプログラミング環境はSyphonに対応しています。AEは、AESyphonというプラグインをインストールすれば出力可能です。(シェアウェアですが、解像度制限のかかった試用版もあります)

投影時のキャリブレーションツールはたくさん出回っていますが、制作時に便利なツールはほとんど無くて。結構今でも展開図から組み上がった所を脳内補完しながら、力技で作っているケースが多い気がします。現場テストになって初めて、少し別角度から観ると全然飛び出て見えない、って分かってしんどい思いを何度かしているので、もし次制作する機会があったら大分楽になるかなぁと思ってます。

バグや不具合、アイディアなどあったらissueかTwitterにリプライください。僕自身が必要なひと通りの機能は実装し終えたとはいえ、このまま放置するのも勿体無いので、もし一緒に開発してくださる方がいたらとても嬉しいです。

今後は制作時につくった汎用性の高いリソースやツールはバシバシ共有していきたいです。今年の目標です。

ディザ (パターン)

PhotoshopのGIF書き出しで選べる「パターン」というディザ補完が好きだったので素材にしてみました。fpsの256秒なの、AEエクスプレッションで扱いやすいと思います。

使い道無いな…